딥러닝에서 흔히 일어나는 오류들을 정리

1. Learning Rate

- large learning rate : overshooting = rate가 너무 크면 step이 너무커서 발산해버릴 수도 있다.

- small learning rate : 너무 오래걸리고 이게 최소점이 아닌데도 멈춘다.

- learning rate는 최소한 0.01에서 시작해야한다. 그리고 cost 함수를 출력해보고 줄일지 말지 결정한다.

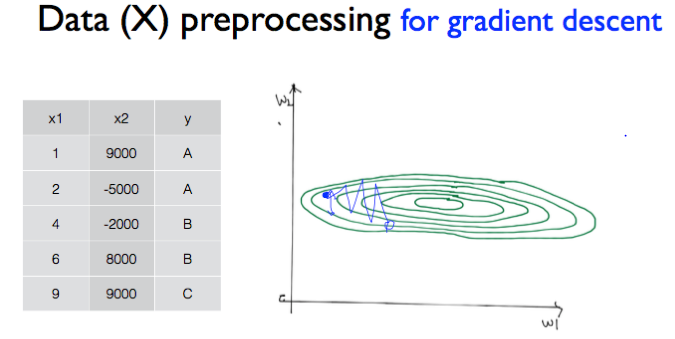

2. Data 간의 Gap

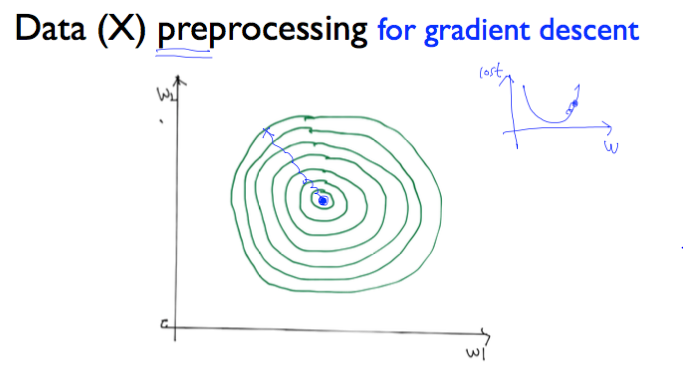

만약 weight가 2개면, x1, x2의 datd 간에 gap이 크지 않을 경우, 다음과 같이 그래프를 나타내며

가운데로 향해서 z축의 값인 cost함수의 최솟값을 찾을 수 있다.

3. Overfitting

- overfitting : training set에만 너무 맞춰져서 test set에는 안 맞는 경우

- 우리가 data 들을 classification을 일반적인 모델로 만들어야 하는데, training set에만 맞춰져 있고 일반화가 안된다면 이는 overfitting이 일어날 확률이 높다.

4. Model 의 복잡성

인공 신경망의 복잡도는 은닉층(hidden layer)의 수나 매개변수의 수 등으로 결정됩니다.

인공 신경망에서는 모델에 있는 매개변수들의 수를 모델의 수용력(capacity)이라고 하기도 합니다.

모델의 수용력이 커지다보면 model이 복잡해져서, 즉 수용할게 많아져서 overfitting이 일어난다는 것이다.

5. Gradient Vanishing or Exploding

- Gradient Vanishing

2020/03/08 - [machine_learning/DL] - DL : Deep Learning 개요 : 인공 신경망, Activation Function

DL : Deep Learning 개요 : 인공 신경망, Activation Function

1. Feed-Forward Neural Network 2. Fully-Connected Layer, Dense Layer 어떤 층의 모든 뉴런이 이전 층의 모든 뉴런과 연결되어있는 층을 전결합층이라고 한다. 위의 그림에서 FFNN에 해당한다. 3. 활성화 함수..

mambo-coding-note.tistory.com

optimize를 하면서 기울기가 손실 혹은 발산을 하는 경우가 존재한다.

'AI' 카테고리의 다른 글

| DL : Keras texts_to_matrix 이해하기 (0) | 2020.03.10 |

|---|---|

| DL : Keres 기초 (0) | 2020.03.10 |

| ML & DL : 오류를 막는 방법 (0) | 2020.03.08 |

| DL : Deep Learning : 개요 : 학습 방법 (0) | 2020.03.08 |

| DL : Deep Learning 개요 : 인공 신경망, Activation Function (0) | 2020.03.08 |

댓글